Tableau Next で関係自動化を実現する AI エンジニアリング

このインタビューはもともと、テクノロジーの未来を形作るエンジニアリングリーダーにスポットライトを当てる Salesforce の Q&A シリーズ「Engineering Energizers」の一部として、Salesforce エンジニアリングブログに掲載されたものです。

ソフトウェアエンジニアリング担当シニアマネージャーである Roni Ben-Oz は、Tableau Next と Data Cloud における AI を活用した関係生成の開発を指揮しています。そのチームは、データオブジェクト間の関係の識別を自動化し、手作業で構成する必要性をなくすことで、ユーザーが構造化データを操作する方法に革命をもたらしています。

このインタビューでは、Roni Ben-Oz のチームがどのようにして、AI によって生成された関係が正確で現実世界のデータと一致していること、リアルタイムのパフォーマンスに最適化されていること、そして大規模なデータセットを処理できるスケーラビリティを備えていることを保証しているかについて理解できます。

チームのミッションについて教えてください。

Roni: Tableau Next と Data Cloud のセマンティックレイヤーである Tableau Semantics 内でデータモデリングの自動化と改善を行い、ユーザーがセマンティックモデルを構築する際にテーブル間の構造化された関係を簡単に作成できるように取り組んでいます。

関係生成を開発した理由は、データ準備の複雑さをなくし、ユーザーが結合や、外部キー、関係の手作業による定義に多くの時間を割くことなく、分析に集中できるようにするためです。AI を活用した自動化を Tableau と Data Cloud のセマンティックモデリングレイヤーに直接埋め込んでいるため、この機能は、精度と効率性を大規模に維持するとともに、複雑なデータ構造と整合させながら関係を検出するのに役立ちます。

関係生成は、基礎的なモデリングレベルで動作します。これにより、AI を活用したクエリとインサイトが、構造化された AI 最適化スキーマに基づいて構築されるようになり、分析ワークロードの精度とパフォーマンスが向上します。

チームは AI 研究者、データプラットフォームチーム、プロダクトエンジニアと連携して関係の検出を改善し、AI 生成による提案を最適化し、Tableau および Salesforce 環境全体で機能をシームレスに統合しました。

AI を活用した関係生成を開発する上で、最大の技術的課題は何でしたか?

Roni: 最大の技術的課題の 1 つは、AI によって生成された関係が現実世界のデータを正確に反映していることを保証することでした。決定論的な SQL 結合とは異なり、AI ベースの関係推論では、スキーマメタデータ、列の類似性、およびユーザーの意図を、コンテキストに基づいて深く理解する必要があります。明示的な外部キー制約や参照整合性制約がない場合でも、システムは関係を推測して検証する必要がありました。

さらに、テーブル間には有効な関係が複数存在する可能性があるため、AI は偽陽性を回避しながら、コンテキストに最も関連のある関係を決定する必要がありました。これを解決するために、列タイプ、スキーマ定義、およびクエリパターンを相互参照する多段階検証パイプラインを開発しました。このパイプラインは、弱い関係や関連性のない関係を除外し、最も有用な可能性が高い関係を保持します。

また、このシステムは Tableau や Data Cloud など、Salesforce のさまざまな環境全体でシームレスに機能する必要がありました。これには、さまざまなデータベースエンジン、メタデータ構造、ガバナンスポリシーにわたって AI 主導の関係検出を標準化し、Salesforce エコシステム全体の適応性と一貫性を確保するためのモジュラーアーキテクチャが必要でした。

AI を活用した関係生成のレイテンシを最適化する上で、最大の技術的課題は何でしたか?

Roni: 最大の課題の 1 つは、大規模言語モデル (LLM) 処理の非効率性と、大規模データセットからのメタデータの取得に関連するネットワーク遅延に対処することでした。関係の検出はリアルタイムで行う必要があるため、応答時間を短縮することは極めて重要な優先事項でした。

LLM の効率性に取り組むために、入力データの最適化に重点を置きました。当初は、完全なスキーマ定義により、不要な計算オーバーヘッドが発生しました。LLM プロンプトを再構築して必須のメタデータのみを含めることで、トークンの消費量が大幅に削減され、推論時間も短縮されました。パフォーマンスをさらに向上させるために、マルチレベルのキャッシュ戦略を実装しました。

さらに、第 2 レベルのキャッシュがトークンの出力長さを動的に調整し、AI が冗長な説明を破棄しながら最も重要なデータのみを返すようにしました。

スキーマの取り込みも再設計し、前処理を効率化しました。これによってシステムは、現在、完全なテーブルスキーマを送信するのではなく、関連するフィールドを選択して抽出します。このアプローチにより、処理する必要があるデータ量が最小限に抑えられます。複雑なスキーマをより効率的に処理するために、並列処理を有効化し、複数の AI クエリを同時に実行できるようにしました。これによって全体的なレイテンシがさらに短縮され、スムーズで応答性の高いユーザーエクスペリエンスが実現しています。

どのようにして、高い精度を維持しながらサービスコストを削減したのでしょうか?

Roni: コスト最適化の取り組みは、サービス品質を維持しながら LLM 推論コストを最小限に抑えることに重点を置いています。すべてのクエリには、入力トークンと出力トークンの使用量に基づいてコストが発生するため、効率が重要な優先事項となります。サービスコストの削減は、次のようにして達成しました。

- 出力トークンの削減: AI 生成による応答内の冗長なメタデータと不要な要素を排除しました。また、生成される関係の数に制限を設けました。効率をさらに最適化するために、パフォーマンス、コスト、処理時間の適切なバランスを実現する LLM モデルを慎重に選択しました。これらの最適化により、重要な関係の詳細のみが保持されると同時に、出力トークン数が減り、コストが削減されています。

- 前処理の最適化: 前処理フェーズは、AI モデルを呼び出さずに一般的な関係ケースを処理できるよう最適化されました。この最適化はルールベースのアプローチとヒューリスティックスに基づいており、AI 推論の量を大幅に削減し、大幅なコスト削減につながります。

- 動的なレート制限: 動的なレート制限のシステムを実装したことで、クエリの複雑さとユーザーの行動に基づいてトークンの割り当てが調整されます。これにより、不要な AI 呼び出しが防止され、効率的なリソース使用が保証されます。

- 信頼性の高い関係のキャッシュ: 頻繁に使用される関係マッピングはキャッシュに保存されます。これにより、冗長な AI クエリの必要性がなくなり、コストが削減され、応答時間が改善されます。

- クエリの重複排除: 同じスキーマを繰り返し分析すると不要な AI 推論コストが発生する可能性がありますが、これを防止します。重複するクエリを識別して回避することで、各分析が効率的になるとともに費用対効果が高くなります。

大規模なデータ処理とユーザーの同時実行に伴うスケーラビリティの課題をどのように解決しましたか?

Roni: 関係生成のスケーラビリティは、特に大規模なデータセットやユーザーの同時実行数が多い場合、複雑な課題となります。私たちのアプローチの中心となるのはセマンティックレイヤーであるため、テーブルのサブセットに焦点を当てることで問題領域を絞り込むことができます。

セマンティックレイヤー内の自動結合機能により、結合の定義が自動化されるため、結合タイプを手作業で指定する必要がなくなります。これによって関係生成が合理化され、効率と正確性が向上します。

もう 1 つの重要な課題は、テーブルが追加されるたびに関係性が指数関数的に増加し、総当たり方式が非現実的になることです。これを解決するために、インテリジェントなスキーマクリーニングメカニズムを導入しました。このメカニズムにより、高い精度と再現率を維持しながらデータセットを最適化し、精度を損なうことなくスケーラビリティを確保できます。

処理のオーバーヘッドを最小限に抑えるために、LLM とのインタラクションをさらに最適化しました。複数の LLM 呼び出しを行う代わりに、単一の呼び出しを使用し、いくつかの並列呼び出しを戦略的に使用して、スマートクリーニングメカニズムを強化します。速度、精度、コスト効率のバランスを実現するこのアプローチにより、高いパフォーマンスを維持しながら効率的に拡張することが可能になります。

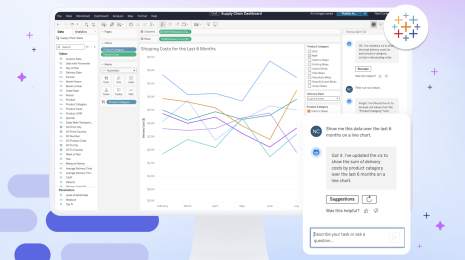

この図は関係生成の概要レベルのプロセスを示しています。Salesforce コアから始まり、セマンティック AI サービスと信頼できる AI プラットフォームを経ていきます。また、テストフレームワーク内の重要な統合ポイントも示しています。

回帰テストと AI 精度の検証はどのように処理していますか?

Roni: 更新間の AI 関係生成の精度を確保するために、回帰を検出する堅牢な検証パイプラインを導入しています。従来のソフトウェアとは異なり、AI システムでは確率的な変動性を導入します。これによって一貫性の検証が複雑になります。そこで、二層構造のテストフレームワークを実装しました。

- 自動回帰テスト: 最初のレイヤーは、CI/CD パイプライン内の自動回帰テストで構成されています。これにより新しい展開において、検証済みの関係マッピングが維持されます。そして、ベースラインの精度しきい値が適用されます。つまり、更新プログラムをリリースする前に最低 80% をカバーする回帰テストが必要になります。これにより、AI によって生成された関係における予期しない変化が防止されます。

- AI ベンチマークと精度/再現率の追跡: 二つ目のレイヤーでは、各 LLM の更新に対して 40 回の反復ベンチマークテストが実行され、精度、再現率、および偽陽性率が測定されます。LLM の非決定論的な性質を考慮すると、精度の監視は単体テストを超えて統計的な傾向分析にまで拡張されます。実稼働のログを分析して、ユーザーによって頻繁に上書きまたは修正される関係を特定します。これにより、実際の精度のフィードバックが得られ、将来のモデルの反復を強化できます。

どのようなセキュリティおよびコンプライアンス対策によって、AI による関係生成の信頼性を確保していますか?

Roni: AI による関係生成の信頼性を確保するには、厳格なセキュリティおよびコンプライアンス対策が必要です。このシステムは多層セキュリティフレームワークを使用して構築されており、それによって企業のデータセットを保護し、データガバナンスポリシーに準拠しています。

大きな課題は、スキーマ情報が AI モデルに送信される際のデータ漏洩を防止することです。これを解決するために、データマスキングレイヤーを実装しました。このレイヤーは、データの構造的整合性を維持しながら、個人を特定できる情報 (PII) や独自のビジネスロジックなどの機密属性を編集します。これにより、AI モデルが正確な関係生成に必要な重要な情報のみを受け取ることができるようになります。

さらに、ロールベースのアクセス制御 (RBAC) とオブジェクトレベルのセキュリティ (OLS) が統合され、ユーザーパーミッションに基づいて関係生成の提案をフィルター処理します。アクセス制御ポリシーはデータベースレベルで適用され、スキーマの可視性と認証トークンに基づいてクエリが制限されます。生成された関係を既知のメタデータ制約に照らして検証するための、AI 応答フィルタリングシステムも導入されています。

もっと詳しく知るには

- Tableau Semantics は、AI が提案する関係を使用してセマンティックモデリングを高速化し、自然言語から計算フィールドを作成します。Tableau Semantics の機能とメリットの詳細についてご覧ください。

- Tableau Next は、統合データレイヤーと信頼できるセマンティクスを活用して、コンテキストに基づくパーソナライズされた実用的なインサイトをあらゆるユーザーに提供します。Tableau Next でエージェンティック分析を開始する方法をご確認ください。